هل يرث الإنسان «تحيزات» الذكاء الاصطناعي؟

رفعت النتائج المذهلة التي حققتها أنظمة الذكاء الاصطناعي مؤخراً، وقدرتها على الدخول في حوارات ممتدة مع البشر، من سقف توقعاتنا للأدوار التي يمكن أن تلعبها في حياتنا في المستقبل القريب. ويقوم كثير من المجالات المهنية الآن بتطبيق أدوات تعتمد على الذكاء الاصطناعي؛ لدعم عملية صنع القرار لدى المتخصصين، وتقليل الأخطاء المحتمل ارتكابها. ومع ذلك، ينبغي معرفة أن هذه التكنولوجيا لا تخلو من المخاطر؛ بسبب احتمالات «التحيز» التي بدأت تظهر ضمن نتائجها يوماً بعد آخر.

أخطاء تولِّد أخطاء

يجب الأخذ في الاعتبار أن البيانات المستخدمة لتدريب نماذج الذكاء الاصطناعي تعكس قرارات بشرية؛ فإذا كانت هذه البيانات تتضمن أنماطاً من الأخطاء المنهجية، فسوف تتعلم خوارزميات الذكاء الاصطناعي هذه الأخطاء وتعيد إنتاجها مجدداً.

ويشير كثير من الأدلة العلمية، بالفعل، إلى أن أنظمة الذكاء الاصطناعي ترث التحيزات البشرية. غير أن الجديد علميّاً هو ما توصلت إليه نتائج الدراسة المنشورة في دورية «ساينتفيك روبوتس» في 3 أكتوبر (تشرين الأول)، من أن التأثير المعاكس قد يحدث، أي أن البشر أيضاً يرثون تحيزات الذكاء الاصطناعي، وهو ما يعني أن تلك التقنيات لن ترث تحيزاتها من البيانات البشرية فحسب، بل يمكن للبشر أن يرثوا تلك التحيزات مجدداً، وبالتالي زيادة خطر الوقوع في حلقة مفرغة لا تنتهي.

وتقول الباحثة الأولى المشاركة في الدراسة، لوسيا فيسنتي، من قسم علم النفس بجامعة ديوستو الإسبانية: «هناك قلق كبير بشأن احتمال قيام الذكاء الاصطناعي بنشر تلك التحيزات في القرارات البشرية». وأضافت لـ«الشرق الأوسط»: «يمكن لمجموعات البيانات المستخدمة لتدريب هذه النماذج أن تخفي أنماطاً من الأخطاء المنهجية وأوجه عدم المساواة، بحيث يتعلم الذكاء الاصطناعي، في كثير من الأحيان، الأخطاء البشرية ويعيد إنتاجها، كما يمكن للبشر توليد تلك التحيزات حتى بعد مرور بعض الوقت على انتهاء التفاعل مع هذه النظم».

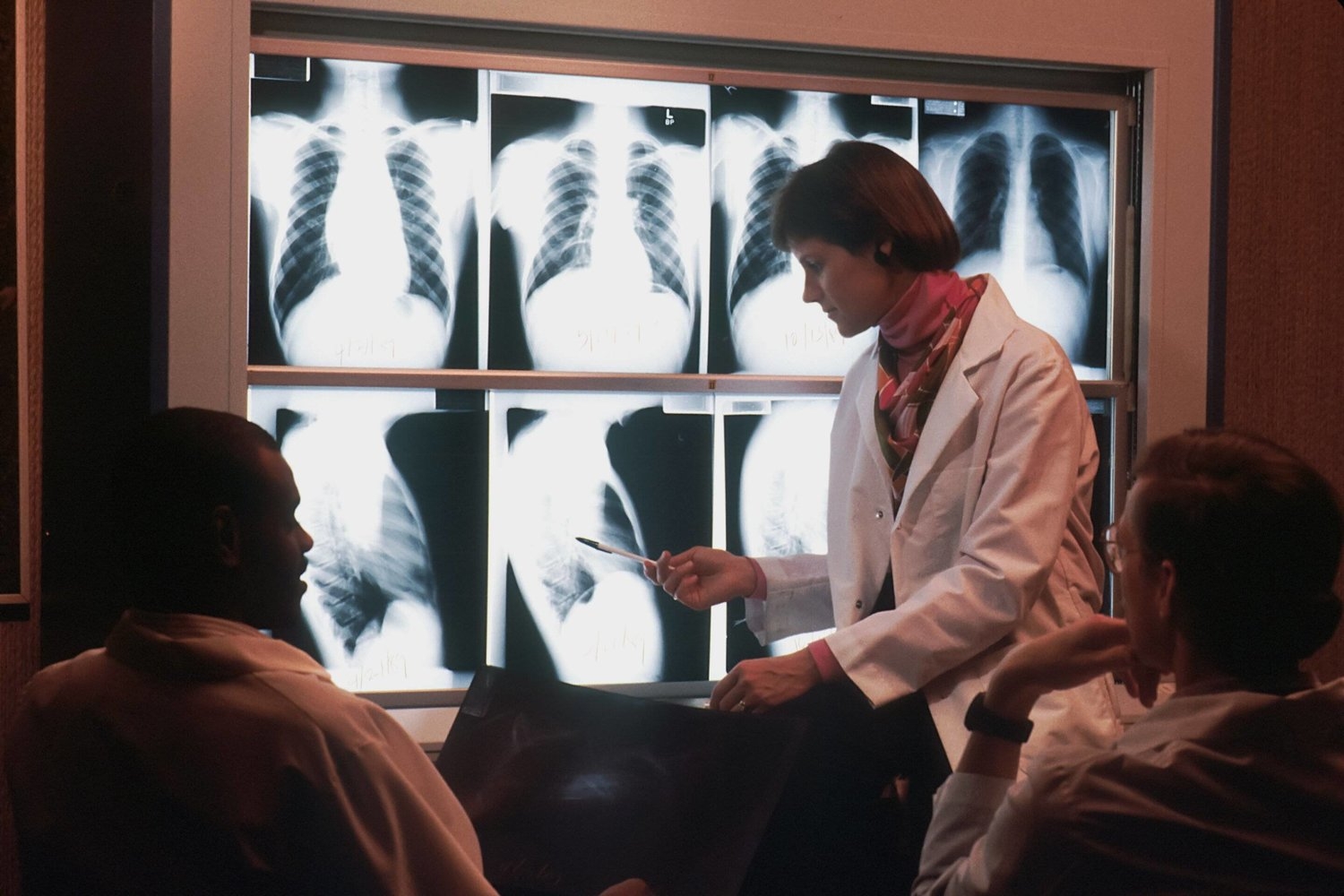

وفي سلسلة تجارب ثلاث أجراها باحثو الدراسة، أجرى متطوعون تشخيصاً طبيّاً (أظهر خطأ منهجيّاً) بمساعدة نظام ذكاء اصطناعي متحيز، في حين لم تحصل مجموعة أخرى ضابطة على أي مساعدة. لقد كانت مهمة التشخيص الطبي بواسطة الذكاء الاصطناعي وهمية. كانت الإعدادات بأكملها عبارة عن محاكاة لتجنب التدخل عند الحاجة لذلك.

وكشفت النتائج أن الأطباء ارتكبوا بمساعدة النماذج التقنية المتحيزة، الأخطاء نفسها التي ارتكبها الذكاء الاصطناعي، في حين لم ترتكب المجموعة الضابطة هذه الأخطاء، وهو ما يعني أن توصيات الذكاء الاصطناعي أثرت على قرارات الأطباء.

تحيز موروث

ومع ذلك، تبقى النتيجة الأكثر أهمية أنه بعد انتهاء عمليات التفاعل مع نظام الذكاء الاصطناعي، استمر هؤلاء الأطباء في محاكاة خطئه المنهجي، حتى عندما تحولوا إلى أداء مهمة التشخيص دون مساعدته. بمعنى آخر، إن الأطباء الذين تلقوا المساعدة أولاً من الذكاء الاصطناعي المتحيز كرروا تحيزهم في سياق آخر جديد من دون هذا الدعم، وبالتالي أظهروا ما يطلق عليه علميّاً «تحيزاً موروثاً». في حين لم تتم ملاحظة هذا التأثير بالنسبة لأطباء المجموعة الضابطة، الذين قاموا بالمهمة دون مساعدة الذكاء الاصطناعي منذ البداية.

وتقول الباحثة المشاركة في الدراسة، الدكتورة هيلينا ماتوتي، من قسم علم النفس بجامعة ديوستو الإسبانية: «توضح هذه النتائج أن المعلومات المتحيزة بواسطة نموذج الذكاء الاصطناعي يمكن أن يكون لها تأثير سلبي دائم على القرارات البشرية». وأضافت لـ«الشرق الأوسط»: «هذا يعني أن الذكاء الاصطناعي لن يرث تحيزاته من البيانات البشرية فحسب، بل يمكن للأشخاص أن يرثوا تلك التحيزات منه، وهو ما ينذر بخطر وقوع البشر في فخ حلقة خطيرة من الأخطاء الممنهجة».

ويشير اكتشاف إمكانية توريث تأثير تحيزات الذكاء الاصطناعي إلى الحاجة لمزيد من الأبحاث النفسية ودراسات متعددة التخصصات حول عمليات التفاعل بين الذكاء الاصطناعي والإنسان. علاوة على ذلك، هناك حاجة إلى التنظيم القائم على الأدلة العلمية؛ لضمان «الوصول إلى تقنيات ذكاء اصطناعي عادلة وأخلاقية»، مع الأخذ في الاعتبار الجوانب النفسية للأنشطة التي ترتكز على التعاون بينه وبين البشر، وليس الميزات التقنية له فقط.

وعن إمكانية تفادي تلك الأخطاء، قالت ماتوتي: «من الضروري تحقيق فهم أفضل لكيفية بناء نماذج الذكاء الاصطناعي للتوقعات والنتائج، والأهم من ذلك نشر المستويات الفعلية لكل من الدقة والأخطاء في تلك النماذج».

وهو ما علقت عليه فيسنتي بالقول: «يمكن لزيادة المعرفة بأخطاء الذكاء الاصطناعي أن تقلل من ثقة الناس المفرطة في تلك النماذج، وربما يمكنهم اكتشاف تحيزاته ومواجهتها مبكراً». وأضافت: «يجب أن يحصل المتخصصون الذين يتعاونون مع الذكاء الاصطناعي على التدريب والوقت اللازمين لاكتشاف أخطائه، وكذلك التقييم الصحيح للنتائج والإجراءات المتولدة عنه عندما يكونون في شك منها».

وتفضل فيسنتي بدلاً من تنبيه البشر للأخطاء المحتملة للذكاء الاصطناعي أن «يتم تنفيذ تلك المهام من قِبل البشر، مع تنبيه نظم الذكاء الاصطناعي للأخطاء المحتملة، ومن ثم تدريبه على تلافيها».

الشرق الاوسط